[Dieser Text erschien zuerst auf Krautreporter am 1. Dezember 2016.]

400.000 sogenannte »Social Bots« sollen dem Kandidaten Donald Trump zum Wahlsieg verholfen haben, berichteten viele Medien. Nun ist auch in Deutschland die Aufregung groß: Angeblich soll auch die AfD Bots eingesetzt haben. Die dementiert das zwar, doch einige Beobachter wollen den Bot-Einsatz nachgewiesen haben.

400.000 sogenannte »Social Bots« sollen dem Kandidaten Donald Trump zum Wahlsieg verholfen haben, berichteten viele Medien. Nun ist auch in Deutschland die Aufregung groß: Angeblich soll auch die AfD Bots eingesetzt haben. Die dementiert das zwar, doch einige Beobachter wollen den Bot-Einsatz nachgewiesen haben.

Aber sind Bots gefährlich? Können sie gar Wahlsiege beeinflussen? Um uns einer Antwort anzunähern, müssen wir sie erst einmal besser verstehen. In Kombination mit »Fake-News«, »Troll-Armeen« und gekauften Facebook-Kommentaren sorgt dieser Tage der Begriff »Social Bot« für eine gehörige Portion Technikverdruss. Weltuntergangsszenarien aus Science-Fiction-Romanen werden beschworen: Das Internet werde von intelligenten Computerprogrammen überrannt, die sich als Menschen tarnen, den politischen Diskurs in sozialen Medien beeinflussen und die Demokratie zerstören.

Der Begriff »Social Bot« wird unhinterfragt weitergetragen, so als wäre er eine Floskel für eine neue bösartige Krankheit aus dem Netz. Dabei ist die Aussage »Bots streuen Propaganda in sozialen Medien« ungefähr so zutreffend, wie »Im Internet stehen viele Unwahrheiten«. Beides nicht falsch, aber sehr einseitig und tendenziös.

Denn Bots in sozialen Medien streuen nicht nur Falschinformationen, betreiben Meinungsmache oder werden für Wahlkämpfe eingesetzt. Sie sind überaus nützlich bis unterhaltsam und können als Prototypen einer neuen Ära der Kommunikationstechnik gesehen werden. Sie werden in absehbarer Zeit auch nicht verschwinden – im Gegenteil: Das Zeitalter der Bots ist gerade erst angebrochen.

Angst ist ein schlechter Ratgeber für eine sachliche Debatte um die Technik. Mal ganz von vorne: Was ist überhaupt ein »Bot«? Ein Versuch, den Begriff zu entzaubern.

Was ist ein Bot?

Ein Bot (englisch robot, »Roboter«) ist ein Computerprogramm, das einfache bis komplexe, oft wiederholbare Aufgaben automatisiert erledigt. Menschen, die Bots programmieren, legen dabei ihren Handlungsspielraum fest. Robotern Intelligenz, Kreativität oder Autonomie zuzuschreiben, ist problematisch, da man menschliche Konzepte auf eine Maschine überträgt. Aber ob eine Maschine diese Eigenschaften – verkürzt gesagt – nur simulieren kann (weil sie stets »Sklave ihrer Programmierung« bleibt), oder ob es völlig egal ist, ob sie die Eigenschaften nur simuliert (sobald sie diese Eigenschaften perfekt nachbildet), sind philosophische und ethische Fragen, die zu klären bleiben.

Ein Bot (englisch robot, »Roboter«) ist ein Computerprogramm, das einfache bis komplexe, oft wiederholbare Aufgaben automatisiert erledigt. Menschen, die Bots programmieren, legen dabei ihren Handlungsspielraum fest. Robotern Intelligenz, Kreativität oder Autonomie zuzuschreiben, ist problematisch, da man menschliche Konzepte auf eine Maschine überträgt. Aber ob eine Maschine diese Eigenschaften – verkürzt gesagt – nur simulieren kann (weil sie stets »Sklave ihrer Programmierung« bleibt), oder ob es völlig egal ist, ob sie die Eigenschaften nur simuliert (sobald sie diese Eigenschaften perfekt nachbildet), sind philosophische und ethische Fragen, die zu klären bleiben.

Über eine Programmierschnittstelle (API, englisch application programming interface) kann ein Bot Daten empfangen und senden. Ein Twitter-Bot, der beispielsweise den Wetterbericht twittert, verbindet sich mit der Schnittstelle eines Wetterdienstes. Von dort bezieht er die Wetterdaten, bevor er sie für eine Veröffentlichung aufbereitet und über die Schnittstelle von Twitter nach draußen sendet und twittert. Twitter ist nur der Ort, an dem der Bot seinen Output platziert. Der Bot könnte genauso gut in ein anderes Soziales Netzwerk schreiben oder eine E-Mail mit dem Wetterbericht versenden.

Solche einfachen Aufgaben können Nutzer ohne Programmierkenntnisse mittlerweile mit Online-Diensten wie IFTTT (»If this then that«) erledigen. Dieser trägt das Funktionsprinzip auch schon im Namen: wenn ich ein neues Foto in meine Dropbox lege, erstelle daraus einen Tumblr-Eintrag und so weiter.

Google, Microsoft, Amazon oder Facebook investieren viel Geld in sprachgesteuerte Systeme und künstliche Intelligenz. Erklärtes Ziel dabei: Bots, mit denen wir Unterhaltungen führen können, die nicht mehr von jenen zu unterscheiden sind, die wir mit Freunden oder Arbeitskollegen haben. Ein Computer, der keinen Bildschirm und keine Maus mehr braucht, sondern nur noch mit Sprache gesteuert wird. Doch das Zeitalter des »conversational interface« (die Abkehr von der grafischen Benutzeroberfläche hin zu einem sprachgesteuerten System) hat gerade erst begonnen. Die Interaktion mit künstlichen Intelligenzen funktioniert in freier Wildbahn noch nicht reibungslos.

Bots, die beispielsweise eine Unterhaltung führen, sich dem Gesprächspartnern anpassen und themenbezogen äußern können, sind in sozialen Medien bisher selten zu finden. Ein bekanntes Beispiel hierfür war der Twitter-Bot »Tay« von Microsoft, der die Gesprächsinhalte verarbeitete, mit denen andere Nutzer ihn fütterten. Er wurde nach kurzer Zeit aber wieder abgeschaltet, weil er sich antisemitisch äußerte und Personen beschimpfte.

Twitter-Bot Tay, der Leute beschimpfte (Tweets nicht mehr existent)

Was ist kein Bot?

Ein Bot ist kein Mensch, der gegen Bezahlung Facebook-Kommentare schreibt, kein Clickworker und kein Angestellter in einer russischen Troll-Agentur, auch wenn diese Themen in letzter Zeit im selben Atemzug genannt werden. Sogenannte »Fake-Follower« auf Twitter konnten bereits 2012 gekauft werden.

Ein Bot ist kein Mensch, der gegen Bezahlung Facebook-Kommentare schreibt, kein Clickworker und kein Angestellter in einer russischen Troll-Agentur, auch wenn diese Themen in letzter Zeit im selben Atemzug genannt werden. Sogenannte »Fake-Follower« auf Twitter konnten bereits 2012 gekauft werden.

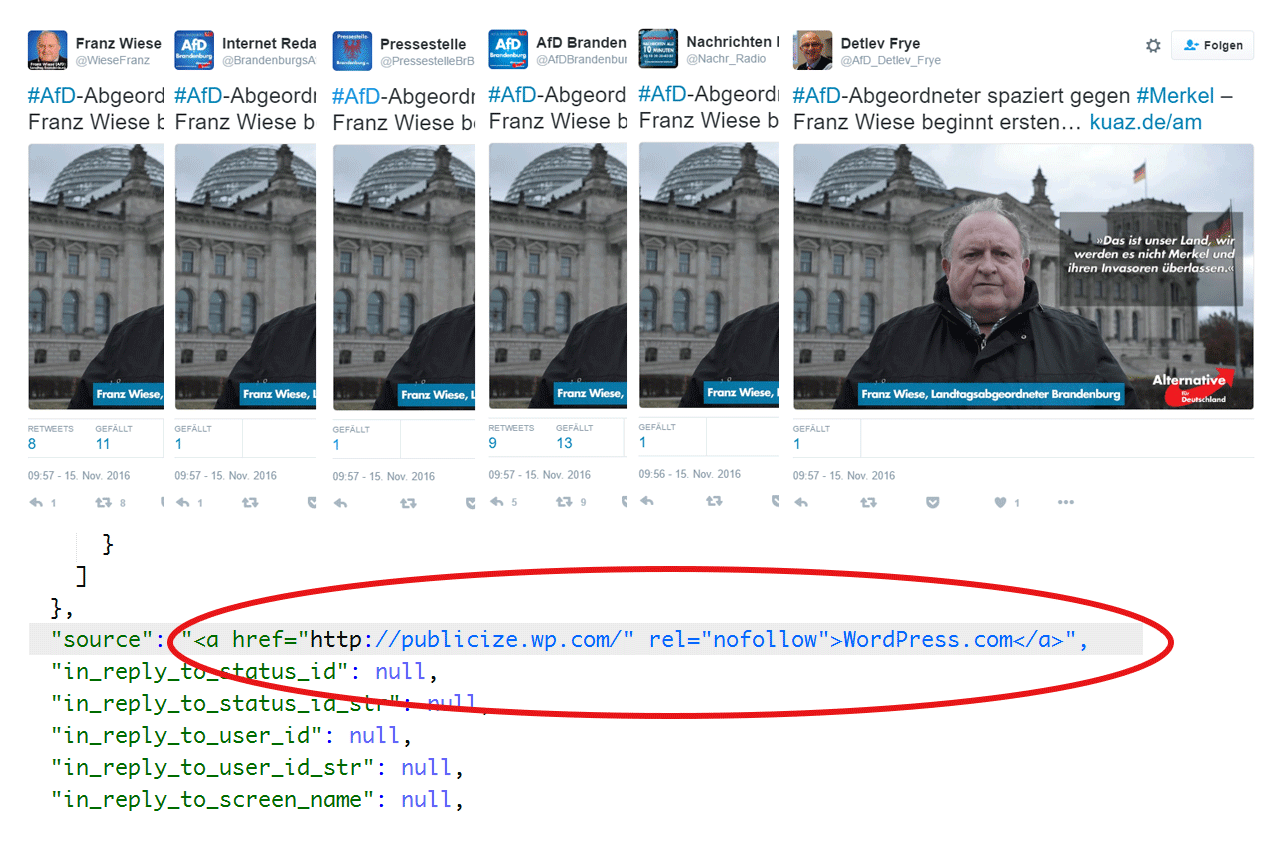

Bots sind auch keine Plugins. WordPress-Plugins etwa machen sich die Schnittstellen der Plattformbetreiber zunutze, um neue Blogbeiträge in den sozialen Medien zu bewerben. Das ist keine Raketenwissenschaft. Ein Blick beispielsweise in die Metadaten von sechs identischen Tweets auf AfD-nahen Accounts verrät das Werkzeug, mit dem diese versandt wurden: WordPress, die Standard-Software für Blogger.

So wie Bots existieren Plugins oder Dienste wie IFTTT, seitdem die Plattformbetreiber ihre Programmierschnittstellen geöffnet haben – bei Twitter und Facebook war das vor über sechs Jahren der Fall. Anzunehmen, die AfD hätte technisch bereits aufgerüstet, ist irreführend (gegen die Twitter-Regeln verstößt das beschriebene Vorgehen dennoch, da den »gleichen Inhalt auf mehreren Accounts posten« unter Spam fällt).

Bots gehören in sozialen Medien dazu

Twitter ist eine beliebte Plattform für Bots und befürwortet den Einsatz von automatisierten Benutzerprofilen. Als Twitter im Jahr 2013 angab, dass fünf Prozent seiner registrierten Profile von Bots betrieben werden (eine Tatsache, die dieser Tage im Zusammenhang mit der Propaganda-Bot-Problematik verdächtig häufig zitiert wird), musste es sich nicht dafür schämen, dass es seine Programmierschnittstelle für Bot-Entwickler geöffnet hat.

Bots gehören in sozialen Medien dazu – im deutschsprachigen Raum findet man sie aber nur selten. Bots sind Teil einer Netzkultur, die von einer großen Gemeinschaft von Bot-Entwicklern weltweit getragen wird. Bot-Entwickler – das sind Kreative, Künstler, Forscher, Autoren oder einfach nur Programmier-Anfänger, die ihren Code in freier Wildbahn austesten wollen. Das Handwerk ist erlernbar und keiner Kaste von Computerwissenschaftlern oder Programmierern vorbehalten.

Bots in sozialen Medien haben sogar Tradition. So fand am 9. April diesen Jahres wieder der Bot Summit im Victoria & Albert-Museum in London statt. Seit vier Jahren treffen dort Bot-Entwickler aus der ganzen Welt aufeinander und präsentieren ihre selbst entwickelten Ergebnisse. Manche ihrer Bots sind beliebt, haben mehrere tausend Follower auf Twitter oder Tumblr, sind unterhaltsam oder haben rein informativen Wert.

Bekannte Bot-Entwickler des Genre Netzkunst sind zum Beispiel Allison Parrish, Darius Kazemi oder Ranjit Bhatnagar. Letzterer ist dafür bekannt, dass er einen Twitter-Bot entwarf, der in Echtzeit Tweets retweetete, die sich nach dem Prinzip des jambischen Fünfhebers reimen.

Doch Bots informieren uns auch über Erdbeben, Ausbrüche von Krankheiten oder werden von Aktivisten genutzt. So machte im Juli 2014 ein Bot Schlagzeilen, der jedes Mal dann einen Tweet absetzte, wenn (meist anonyme) Autoren Wikipedia-Einträge aus regierungsnahen Gebäuden bearbeiteten. Das Ziel dabei: politische Einflussnahme und Propaganda in der Enzyklopädie aufzudecken.

Donald Payne Jr. Wikipedia article edited anonymously from US House of Representatives https://t.co/wXd9F3qly6

— congress-edits (@congressedits) October 20, 2016

Ein Bot, der sich an @CongressEdits orientierte und die russischsprachige Wikipedia beobachtete, sorgte sogleich für Furore. Denn ein Angestellter des russischen Staatsfernsehen hatte einen Eintrag über den Abschuss der Passagiermaschine des Fluges MH17 über der Ukraine verändert. In einem Wikipedia-Artikel über Flugzeugabstürze war zu lesen, dass das Passagierflugzeug von Terroristen der selbsternannten Volksrepublik Donezk mit Hilfe eines Raketensystems abgeschossen wurde, das sie von Russland erhalten hatten. Der Autor änderte diese Textzeile im Sinne der Propaganda seiner Regierung: »Das Flugzeug [Flug MH17] wurde von ukrainischen Soldaten abgeschossen«.

Die Ergebnisse der Bot-Community sind virtuos und stecken die Möglichkeiten der digitalen Räume, in denen sie eingebettet sind, stets aufs Neue ab. Einen Eindruck davon, was Bots in sozialen Medien alles können, vermitteln Bot-Verzeichnisse, wie Botwiki oder Botpages.

So intelligent wie Siri, so böse wie der IS

Es ist schade, dass uns eine aufgeschlossene Sicht auf die Bot-Kultur in Deutschland verwehrt bleibt und wir uns stattdessen damit beschäftigen müssen, wie gefährlich dieses Internet ist: Damit, dass Bots Hetze und Falschinformation verbreiten, »Nutzer auf Sexportalen in die Abo-Falle locken« oder Propaganda für den »Islamischen Staat« streuen. Okay – hier steht zumindest, dass Bots den Wetterbericht oder die Lokalnachrichten twittern können. Dort allerdings existieren, außer Propaganda-Bots, scheinbar nur Spam-Bots im Internet.

Simon Hegelich, Professor für Data Science an der TU München, ist dieser Tage ein viel zitierter Mann (und in der Überzahl aller Interviews zum Thema zu finden). Auf Deutschlandradio Kultur sagte er, der Effekt, den die Propaganda-Bots tatsächlich haben, sei noch gar nicht belegt. Die bekannte Vorstellung, soziale Medien würden weiterhin »das, was in unserer Gesellschaft passiert, spiegeln« könne allerdings kritisch betrachtet werden.

Bots in sozialen Medien nachzusagen, sie würden menschliches Verhalten nachahmen, ist irreführend. Zwar stimmt es, dass Apples Siri eine Gesprächssituation nachahmen kann. Aber die Bots, auf die sich die Berichterstattungen stützen, sind mit großer Wahrscheinlichkeit keine künstlichen Intelligenzbestien. Sondern mechanische Computerprogramme, deren Fähigkeiten überschaubar sind: sie reagieren auf Schlagworte, teilen Inhalte, folgen anderen Nutzern oder twittern zufällig Phrasen aus einer Textsammlung.

Es mag stimmen, dass 400.000 Bots zum Vorteil von Donald Trump während des Wahlkampfes in den USA twitterten. Aber wirft man einen genauen Blick auf die Studie, die in Berichterstattungen oder Fachartikeln dieser Tage direkt (1, 2, 3) oder indirekt zitiert wird, stellt sich heraus, dass die Autoren nach einer Siri-Armee gar nicht gesucht haben. Der Kriterienkatalog, nach dem die Autoren der Studie Twitter-Accounts in Mensch oder Maschine unterteilt haben, berücksichtigt primitive Computerprogramme, die nach einem einfachen Ablaufschema funktionieren, keine künstlichen Intelligenzen.

Posthumanistisches Zeitalter

»Bei Twitter ist es schon so weit, dass man als Nutzer nicht mehr zwischen Bot und Mensch unterscheiden kann«, sagt Simon Hegelich. Das mag sein. Denn ein Bot erscheint auf Twitter wie jeder andere Account und ist dank der Programmierschnittstelle von Twitter mit denselben Funktionen ausgestattet, die einem Menschen zur Verfügung stehen, der Twitter im Webbrowser bedient. Bot-Programmierer können die Funktionen Like, tweet, retweet, follow programmatisch ansteuern. Mit wenigen Klicks kann jeder Nutzer einen Twitter- oder Facebook-Account für eine automatisierte Nutzung einrichten, auch im Parallelbetrieb. Und genau das ist das Reizvolle an der Bot-Entwicklung und beflügelt viele Menschen zum Beispiel in der Überlegung, eine Programmiersprache zu lernen und/oder sich mit der Technik auseinanderzusetzen, die sie oder ihn umgibt.

Es trägt nicht zur Versachlichung der Debatte bei, wenn wir vorschnell ein posthumanistisches Zeitalter ausrufen, in dem nichts bleibt, als sich so gut wie möglich zu schützen, weil wir unsere Mitmenschen nicht mehr von Maschinen unterscheiden können. Dass Bots für einen Wahlkampf eingesetzt werden, ist vielleicht nur ein Symptom unserer Zeit. Die Antwort auf die Frage, wie mit ihnen umzugehen ist, kann nicht defensiv bleiben. Denn wir werden uns ohnehin an die Bots gewöhnen müssen – oder wie der Atlantic kürzlich schlussfolgerte:

»Da die Wahrnehmung und der Gebrauch von Bots zunimmt, wird der Druck auf Regierungen, NGOs und Forschungseinrichtungen um so größer sein, Bots selber zu programmieren, die die Zivilgesellschaft stärken – und nicht Menschen davon überzeugen, für einen bestimmten (Präsidentschafts-) Kandidaten zu wählen.«

Zur Erinnerung: Der Turing-Test ist eine Chat-Situation, in der ein Bot einen Menschen davon überzeugt, dass er kein Bot, sondern ein Mensch ist. Der mit 100.000 US-Dollar und einer Goldmedaille dotierte Loebner-Preis, der an Personen verliehen wird, dessen Computerprogramm den Turing-Test knackt, hat noch niemand gewonnen. Und dieser Preis wird voraussichtlich nicht mit »Social Bots« im Bundestagswahlkampf 2017 zu gewinnen sein.

Zur Erinnerung: Der Turing-Test ist eine Chat-Situation, in der ein Bot einen Menschen davon überzeugt, dass er kein Bot, sondern ein Mensch ist. Der mit 100.000 US-Dollar und einer Goldmedaille dotierte Loebner-Preis, der an Personen verliehen wird, dessen Computerprogramm den Turing-Test knackt, hat noch niemand gewonnen. Und dieser Preis wird voraussichtlich nicht mit »Social Bots« im Bundestagswahlkampf 2017 zu gewinnen sein.

Illustrationen: Thomas Weyres & Sibylle Jazra für Krautreporter. Redaktion: Theresa Bäuerelein. Produktion: Sebastian Esser.